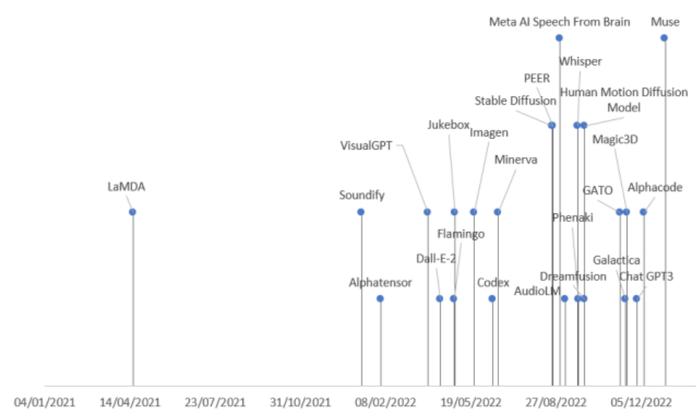

过去的两年时间里,AI界的大型生成模型发布呈井喷之势,尤其是Stable Diffusion开源和ChatGPT开放接口后,更加激发了业界对生成式模型的热情。

但生成式模型种类繁多,发布速度也非常快,稍不留神就有可能错过了sota

最近,来自西班牙科米利亚斯主教大学的研究人员全面回顾了各个领域内AI的最新进展,将生成式模型按照任务模态、领域分为了九大类,并总结了2022年发布的21个生成式模型,一次看明白生成式模型的发展脉络!

论文链接:https://arxiv.org/abs/2301.04655

论文链接:https://arxiv.org/abs/2301.04655生成式AI分类

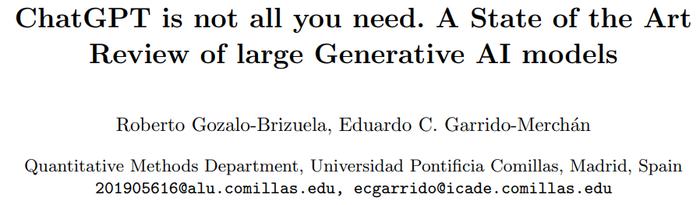

模型可以按照输入和输出的数据类型进行分类,目前主要包括9类。

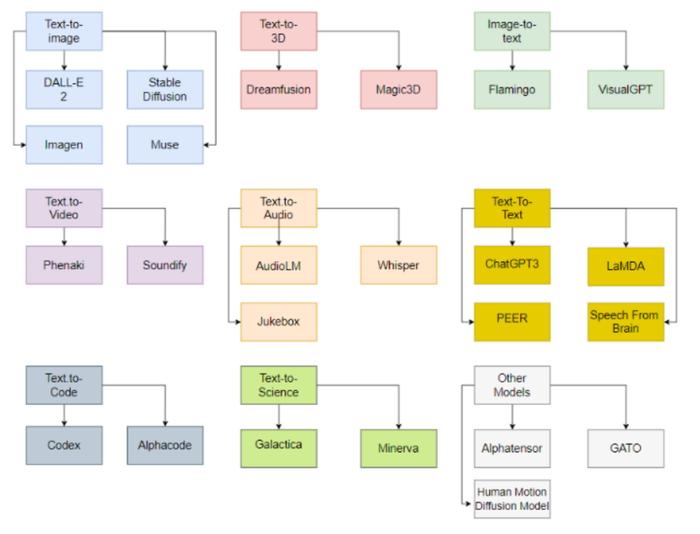

有趣的是,在这些已发布大模型的背后,只有六个组织(OpenAI, Google, DeepMind, Meta, runway, Nvidia)参与部署了这些最先进的模型。

其主要原因是,为了能够估计这些模型的参数,必须拥有极其庞大的计算能力,以及在数据科学和数据工程方面高度熟练且经验丰富的团队。

因此,也只有这些公司,在收购的初创公司和与学术界合作的帮助下,能够成功部署生成式人工智能模型。

在大公司参与初创企业方面,可以看到微软向OpenAI投资了10亿美元,并帮助他们开发模型;同样,谷歌在2014年收购了Deepmind。

在大学方面,VisualGPT是由阿卜杜拉国王科技大学(KAUST)、卡内基梅隆大学和南洋理工大学开发的,Human Motion Diffusion模型是由以色列特拉维夫大学开发的。

同样,其他项目也是由一家公司与一所大学合作开发的,比如Stable Diffusion由Runway、Stability AI和慕尼黑大学合作开发;Soundify由Runway和卡内基梅隆大学合作开发;DreamFusion由谷歌和加州大学伯克利分校合作。

Text-to-image模型

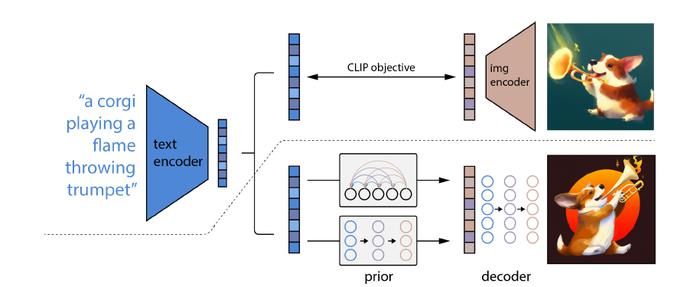

DALL-E 2

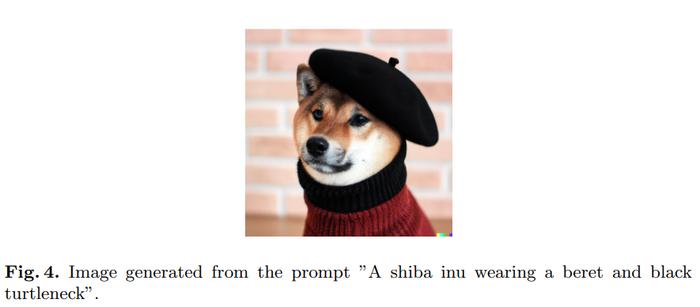

由OpenAI开发的DALL-E 2能够从由文本描述组成的提示中生成原始、真实、逼真的图像和艺术,而且OpenAI已经对外提供了API来访问该模型。

DALL-E 2特别之处在于它能够将概念、属性和不同风格结合起来,其能力源于语言-图像预训练模型CLIP神经网络,从而可以用自然语言来指示最相关的文本片段。

具体来说,CLIP embedding有几个理想的属性:能够对图像分布进行稳定的转换;具有强大的zero-shot能力;并且在微调后实现了最先进的结果。

为了获得一个完整的图像生成模型,CLIP图像embedding解码器模块与一个先验模型相结合,从一个给定的文本标题中生成相关CLIP图像embedding

其他的模型还包括Imagen,Stable Diffusion,Muse

Text-to-3D模型

对于某些行业,仅能生成2D图像还无法完成自动化,比如游戏领域就需要生成3D模型。

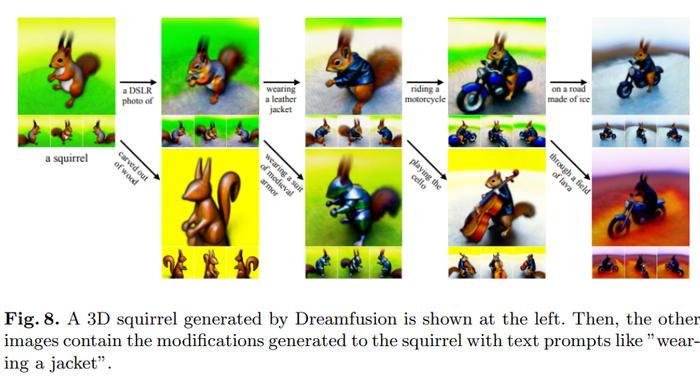

Dreamfusion

DreamFusion由Google Research开发,使用预先训练好的2D文本到图像的扩散模型来进行文本到3D的合成。

Dreamfusion使用一个从二维扩散模型的蒸馏中得到的损失取代了CLIP技术,即扩散模型可以作为一个通用的连续优化问题中的损失来生成样本。

相比其他方法主要是对像素进行采样,在参数空间的采样比在像素空间的采样要难得多,DreamFusion使用了一个可微的生成器,专注于创建从随机角度渲染图像的三维模型。

其他模型如Magic3D由英伟达公司开发。

Image-to-Text模型

获得一个描述图像的文本也是很有用的,相当于图像生成的逆版本。

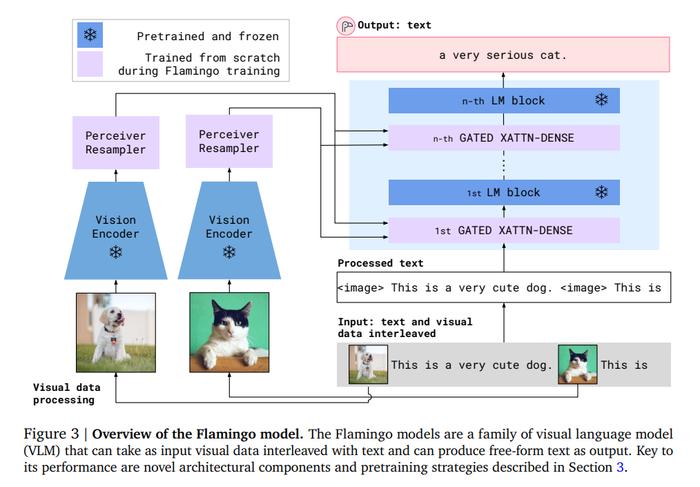

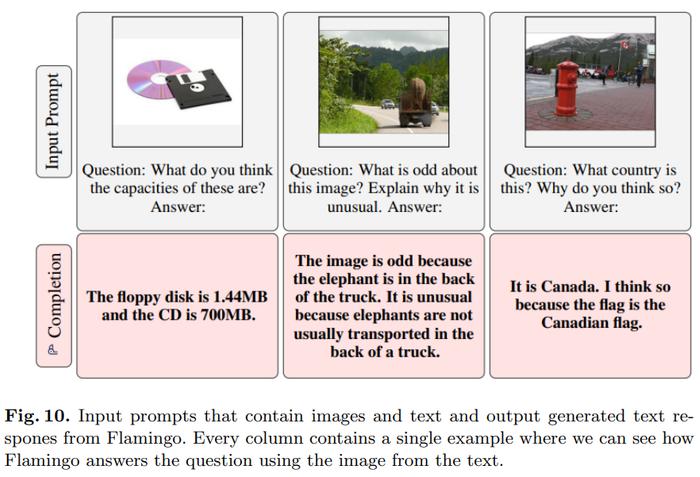

Flamingo

该模型由Deepmind开发,在开放式的视觉语言任务上,只需通过一些输入/输出例子的提示,即可进行few-shot学习。

具体来说,Flamingo的输入包含视觉条件下的自回归文本生成模型,能够接收与图像或视频交错的文本token序列,并生成文本作为输出。

用户可以向模型输入query,并附上一张照片或一段视频,模型就会用文本答案来回答。

Flamingo模型利用了两个互补的模型:一个是分析视觉场景的视觉模型,一个是执行基本推理形式的大型语言模型。

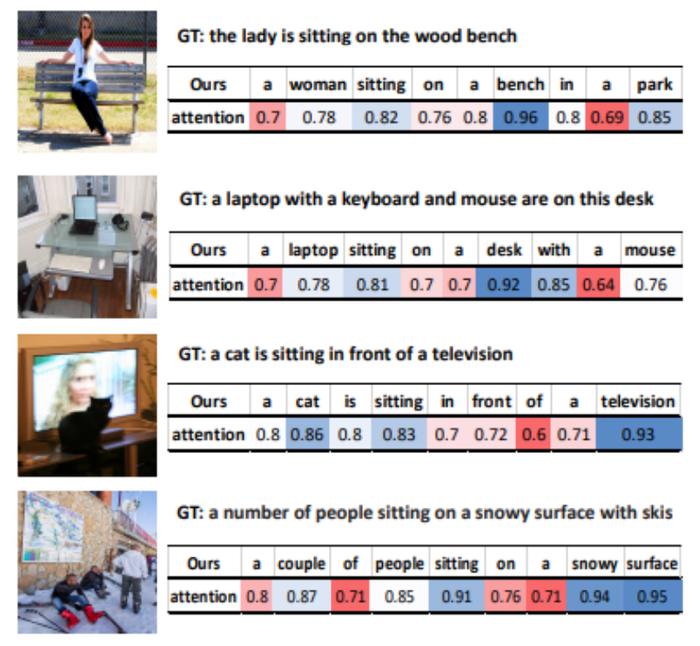

VisualGPT

VisualGPT是一个由OpenAI开发的图像描述模型,能够利用预训练语言模型GPT-2中的知识。

为了弥合不同模态之间的语义差距,研究人员设计了一个全新的编码器-解码器注意力机制,具有整流门控功能。

VisualGPT最大的优点是它不需要像其他图像到文本模型那样多的数据,能够提高图像描述模型的数据效率,能够在小众领域得到应用或对少见的物体的进行描述。

Text-to-Video模型

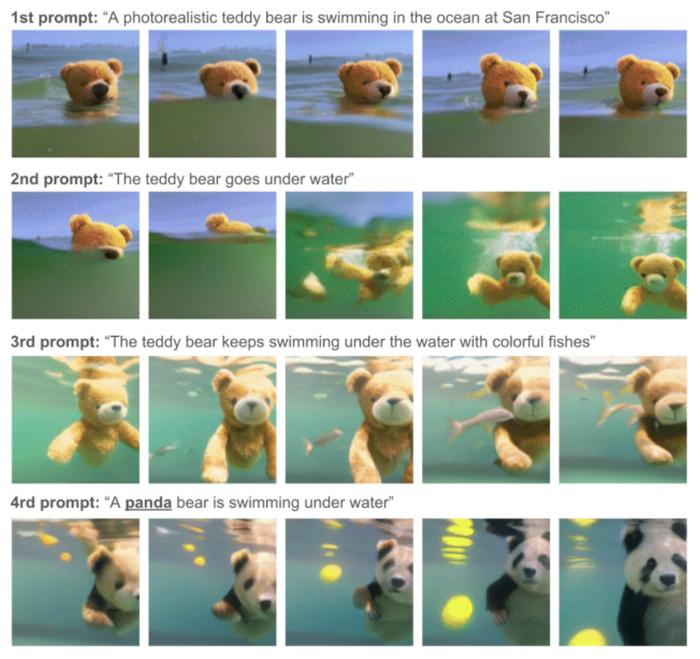

Phenaki

该模型由Google Research开发制作,可以在给定一连串文字提示的情况下,进行真实的视频合成。

Phenaki是第一个能够从开放域时间变量提示中生成视频的模型。

为了解决数据问题,研究人员在一个大型的图像-文本对数据集以及数量较少的视频-文本例子上进行联合训练,最终获得了超越视频数据集中的泛化能力。

主要是图像-文本数据集往往有数十亿的输入数据,而文本-视频数据集则小得多,并且对不同长度的视频进行计算也是一个难题。

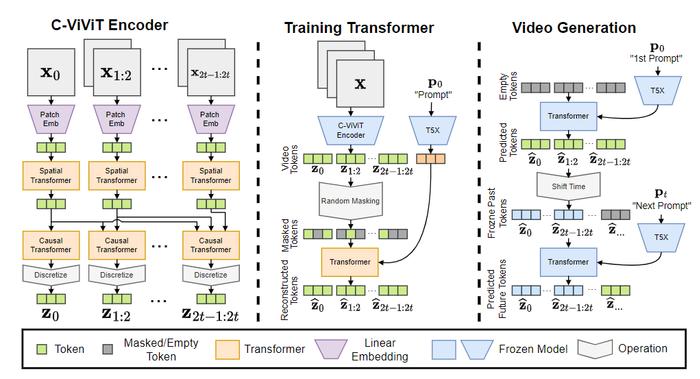

Phenaki模型包含三个部分:C-ViViT编码器、训练Transformer和视频生成器。

将输入token转换为embedding后,接着经过时序Transformer和空间Transformer,再使用一个没有激活的单一线性投影,将token映射回像素空间。

最终模型可以生成以开放域提示为条件的时间连贯性和多样性的视频,甚至能够处理一些数据集中不存在的新概念。

相关模型包括Soundify.

Text-to-Audio模型

对于视频生成来说,声音也是必不可缺的部分。

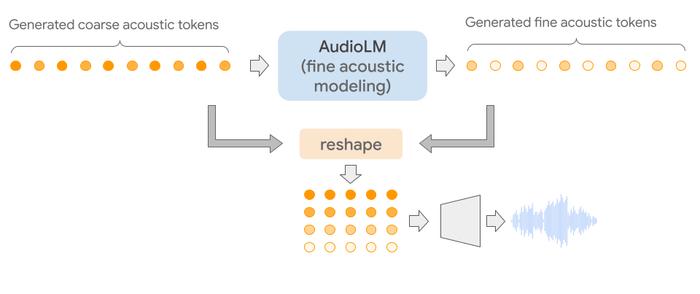

AudioLM

该模型是由谷歌开发,可用于生成高质量的音频,并具有长距离一致性。

AudioLM的特别之处在于将输入的音频映射成一个离散的token序列,并将音频生成作为该表示空间的语言建模任务。

通过对原始音频波形的大型语料库进行训练,AudioLM成功学会了在简短的提示下生成自然和连贯的连续的语音。这种方法甚至可以扩展到人声之外的语音,比如连续的钢琴音乐等等,而不需要在训练时添加符号表示。

由于音频信号涉及多个尺度(scale)的抽象,所以音频合成时使得多尺度在显示一致性的同时实现高音频质量非常具有挑战性。AudioLM模型通过结合神经音频压缩、自监督表示学习和语言建模方面的最新进展来实现。

在主观评价方面,评分者被要求听一个10秒的样本,并决定它是人类讲话还是合成的语音。基于收集到的1000个评分,比率为51.2%,与随机分配标签没有统计学差异,即人类无法区分合成和真实的样本。

其他相关模型包括Jukebox和Whisper

Text-to-Text模型

问答任务常用。

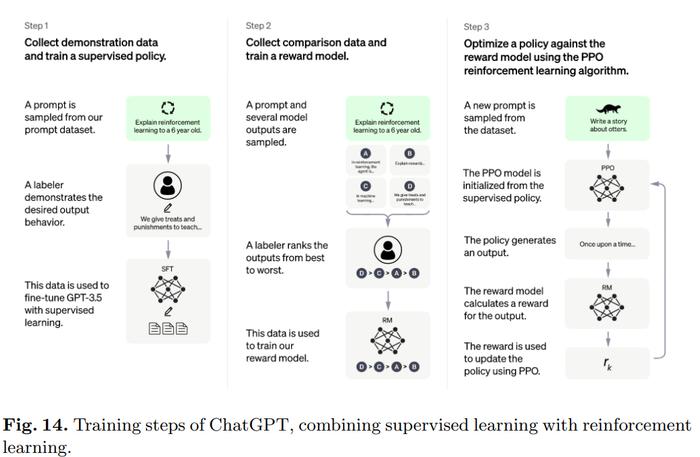

ChatGPT

广受欢迎的ChatGPT由OpenAI开发,以对话的方式与用户进行互动。

用户提出一个问题,或是提示文本的前半部分,模型会补全后续部分,并且能够识别出不正确的输入前提并拒绝不恰当的请求。

具体来说,ChatGPT背后的算法是Transformer,训练过程主要是人类反馈的强化学习。

最初的模型是使用监督学习下的微调来训练的,然后由人类来提供对话,在对话中他们互相扮演用户和人工智能助理,然后由人修正模型返回的回复,并用正确的答案帮助模型改进。

将制作的数据集与InstructGPT的数据集混合在一起,转换为对话格式。

其他相关模型包括LaMDA和PEER

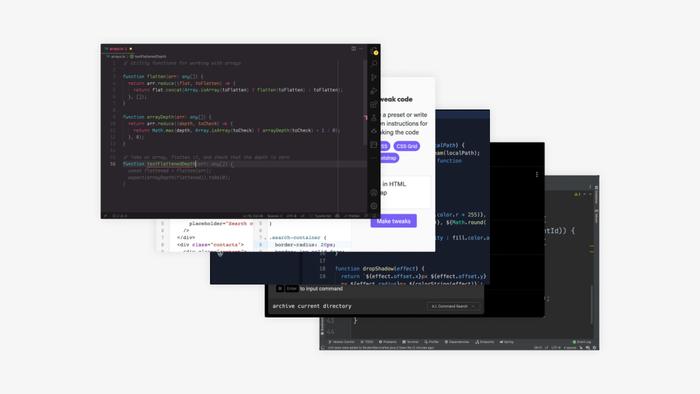

Text-to-Code模型

和text-to-text类似,只不过生成的是特殊类型的文本,即代码。

Codex

该模型由OpenAI开发,可以将文本翻译成代码。

Codex是一种通用的编程模型,基本上可以应用于任何编程任务。

人类在编程时的活动可以分为两部分:1)将一个问题分解成更简单的问题;2)将这些问题映射到已经存在的现有代码(库、API或函数)中。

其中第二部分是对程序员来说最浪费时间的部分,也是Codex最擅长的地方。

训练数据于2020年5月从GitHub上托管的公共软件库中进行收集,包含179GB的Python文件,并在GPT-3的基础上进行微调,其中已经包含了强大的自然语言表征。

相关模型还包括Alphacode

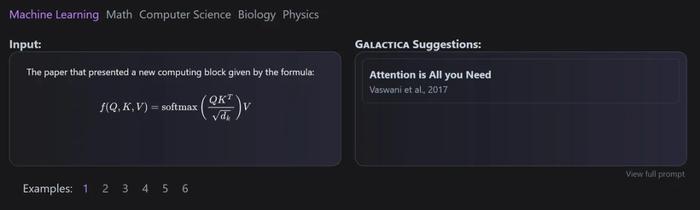

Text-to-Science模型

科研文字也是AI文本生成的目标之一,但要取得成果仍然有很长的路要走。

Galactica

该模型是由Meta AI和Papers with Code联合开发的,可用于自动组织科学文本的大型模型。

Galactica的主要优势在于即便进行多个episode的训练后,模型仍然不会过拟合,并且上游和下游的性能会随着token的重复使用而提高。

并且数据集的设计对该方法至关重要,因为所有的数据都是以通用的markdown格式处理的,从而能够混合不同来源的知识。

引文(citations)通过一个特定的token来处理,使得研究人员可以在任何输入上下文中预测一个引文。Galactica模型预测引文的能力会随着规模的提升而提高。

此外,该模型在仅有解码器的设置中使用了一个Transformer架构,对所有尺寸的模型进行了GeLU激活,从而可以执行涉及SMILES化学公式和蛋白质序列的多模态任务,

Minerva

Minerva的主要目的就是解决决数学和科学问题,为此收集了大量的训练数据,并解决了定量推理问题,大规模模型开发问题,还采用了一流的推理技术。

Minerva采样语言模型架构通过使用step-by-step推理来解决输入的问题,即输入是需要包含计算和符号操作,而不用引入外部工具。

其他模型

还有一些模型不属于前面提到的类别。

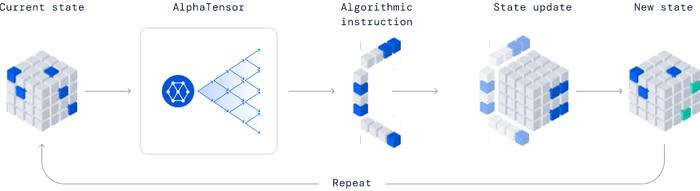

AlphaTensor

由Deepmind公司开发,因其发现新算法的能力,在业界是一个完全革命性的模型。

在已公布的例子中,AlphaTensor创造了一种更有效的矩阵乘法算法。这种算法非常重要,从神经网络到科学计算程序都可以从这种高效率的乘法计算中受益。

该方法基于深度强化学习方法,其中智能体AlphaTensor的训练过程就是玩一个单人游戏,目标是在有限的因子空间内寻找张量分解。

在TensorGame的每一步,玩家需要选择如何结合矩阵的不同entries来进行乘法,并根据达到正确的乘法结果所需的操作数量来获得奖励分数。AlphaTensor使用一种特殊的神经网络架构来利用合成训练游戏(synthetic training game)的对称性。

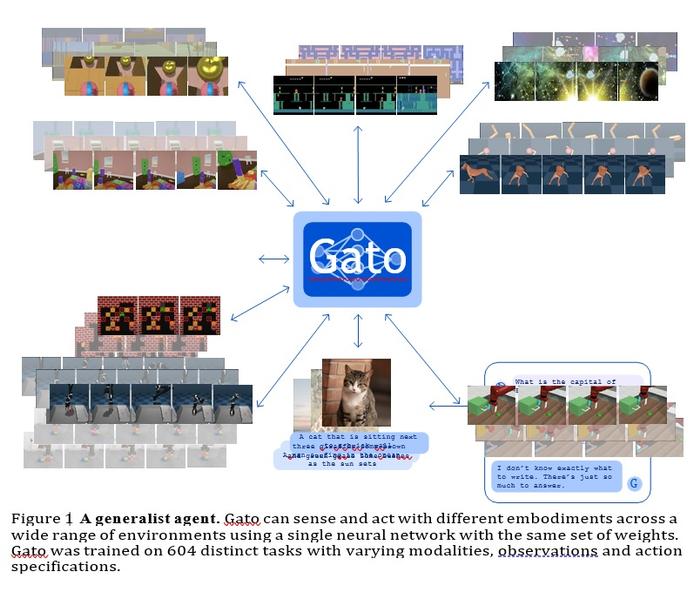

GATO

该模型是由Deepmind开发的通用智能体,它可以作为一个多模态、多任务或多embodiment泛化策略来使用。

具有相同权重的同一个网络可以承载非常不同的能力,从玩雅达利游戏、描述图片、聊天、堆积木等等。

在所有任务中使用单一的神经序列模型有很多好处,减少了手工制作具有自身归纳偏见策略模型的需要,并增加了训练数据的数量和多样性。

这种通用智能体在大量任务中都取得了成功,并且可以用很少的额外数据进行调整,以便在更多的任务中取得成功。

目前GATO大约有1.2B个参数,可以实时控制现实世界机器人的模型规模。

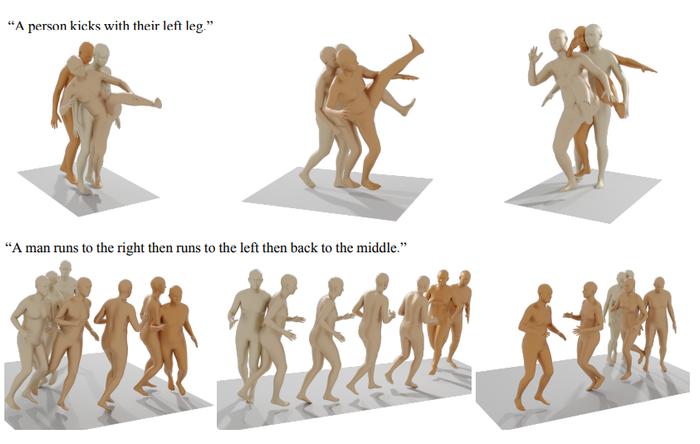

其他已发表的生成性人工智能模型包括生成human motion等。

- 01 女排世联赛中国3-0波兰 9胜3负排名第4晋级总决赛

- 02 G7晚宴意大利总理梅洛尼的眼神,感觉能杀死马克龙

- 03 周末重磅!央行放利好,证监会重磅预告!国资委、工信部出手……影响一周市场的十大消息(新股+点评)

- 04 吴英杰被查:长期在西藏工作,曾任西藏自治区党委书记

- 05 中国女排世联赛分站赛第4收官 总决赛与日本争4强

图片新闻

印度多地发生火灾

印度多地发生火灾

动物界“奶爸”

动物界“奶爸”

晚霞与彩虹相遇

晚霞与彩虹相遇

上千米高空!女兵乘运20演练跳伞

上千米高空!女兵乘运20演练跳伞

凯特王妃公开露面

凯特王妃公开露面

加沙难民自称像行尸走肉

加沙难民自称像行尸走肉

地铁被诬偷拍案男子将带货

地铁被诬偷拍案男子将带货

邻居讲述“天才少女”姜萍

邻居讲述“天才少女”姜萍

新媒体实验室

-

朋友圈47%的内容在炫耀

朋友圈47%的内容在炫耀

-

近300起杀妻案如何判罚

近300起杀妻案如何判罚

-

谈恋爱反降低生活质量?

谈恋爱反降低生活质量?

-

全国最能吃的省市竟是它

全国最能吃的省市竟是它

-

性犯罪者再犯几率达12.8%

性犯罪者再犯几率达12.8%

举报邮箱:jubao@vip.sina.com

Copyright © 1996-2024 SINA Corporation

All Rights Reserved 新浪公司 版权所有